| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | ||||

| 4 | 5 | 6 | 7 | 8 | 9 | 10 |

| 11 | 12 | 13 | 14 | 15 | 16 | 17 |

| 18 | 19 | 20 | 21 | 22 | 23 | 24 |

| 25 | 26 | 27 | 28 | 29 | 30 | 31 |

- Algorithm

- 재귀함수

- dfs

- OS

- CS

- 투포인터

- 신나는함수실행

- Virtual Memory

- 정렬

- 파이썬

- Python

- 코딩테스트

- 재귀

- 백준

- two pointer

- python3

- 브루트포스

- 알고리즘

- BF

- 머신러닝

- Loss

- 완전탐색

- Github

- 1일1솔

- 백트래킹

- sort

- 프로그래머스

- 코테

- ML

- backtracking

- Today

- Total

이것저것 공부 기록하기

[Paper Review] FastSpeech 2: Fast and High-Quality End-to-End Text to Speech (ICLR 2021) 본문

[Paper Review] FastSpeech 2: Fast and High-Quality End-to-End Text to Speech (ICLR 2021)

얍욥얍 2022. 9. 10. 18:53제목: FastSpeech2: Fast and High-Quality End-to-End Text to Speech

저자: Yi Ren, Chenxu Hu, Xu Tan, Tao Qin, Sheng Zhao, Zhou Zhao, Tie-Yan Liu

소속: Zhejiang University, Microsoft Research Asia, Microsoft Azure Speech

발표: ICLR 2021

논문: https://arxiv.org/abs/2006.04558

오디오샘플: https://speechresearch.github.io/fastspeech2/

1. Introduction

Previous Work: FastSpeech

- Non-autoregressive TTS 모델들 중, FastSpeech는 가장 successful한 모델 중 하나

- FastSpeech는 one-to-many mapping problem을 경감시킬 수 있는 두 가지 방안을 제시함

- one-to-many mapping problem 이란 하나의 text에 대해서도 매우 다양한 speech가 나올 수 있다는 의미 (예를 들어, 사람에 따라 억양이나 어조, 말하는 스타일이 다름)

- Knowledge Distillation

- duration information

- 하지만 이런 방식은 여러 단점이 존재함

- two-stage teacher-student 학습 파이프라인은 학습 과정을 복잡하게 함

- teacher 모델로부터 생성된 target mel-spectrogram은 information loss 가 일어나서 ground-truth에 비해 음성합성 퀄리티가 떨어짐

- teacher 모델의 attention map에서 추출된 duration이 충분히 정확하지 않음

따라서, 이러한 FastSpeech의 이슈 사항을 다루고 non-autoregressive TTS에서의 one-to-many mapping problem을 더 잘 다룰 수 있도록 하는 FastSpeech2를 소개함

2. FastSpeech2 and 2s

2.1 Motivation

- TTS는 전형적으로 one-to-many problem 을 갖고 있음

- 이러한 one-to-many problem이 생기는 이유는 speech의 variation(ex. pitch, duration, sound volume, prosody)로 인해 text sequence에 대하여 다양한 speech sequences가 가능하기 때문

- non-autoregressive TTS에서는 text가 유일한 input 정보이기 때문에 speech의 variance를 충분히 예측할 수 없음

- 이 경우, 모델은 일반화가 잘 안 되어 training set에 있는 target speech의 variation에 오버피팅되는 경향이 있음

- FastSpeech는 이러한 one-to-many problem을 경감하기 위한 두 가지 방법을 고안했지만, 그에 따른 이슈들을 가져왔음 (1. 복잡한 파이프라인 / 2. information loss / 3. 충분히 정확하지 않은 ground-truth duration)

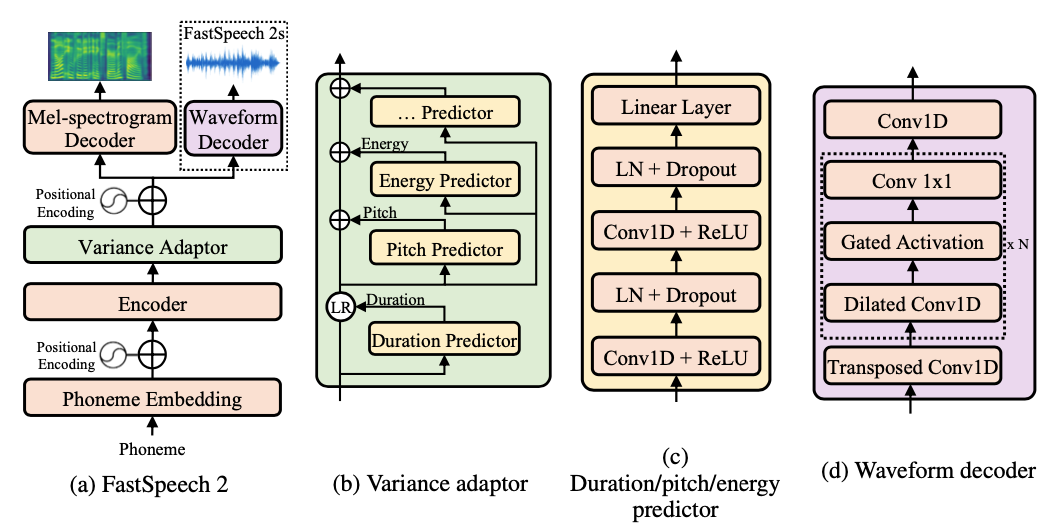

2.2 Model Overview

- (a: overall architecture)

- encoder는 phoneme embedding sequence를 phoneme hidden sequence로 변환시킴

- 그 후, variance adaptor는 variance(ex. duration, pitch, energy)들을 hidden sequence에 더함

- 마지막으로, mel-spectrogram decoder는 adapted hidden sequence를 mel-spectrogram sequence로 변환함

- encoder와 mel-spectrogram decoder의 기본구조로는 self-attention layer와 1D-conv를 쌓은 feed-forward Transformer를 사용

- FastSpeech와의 차이점은 teacher-student distillation 파이프라인과 teacher model로부터의 phoneme duration 이 있음

- FastSpeech2에서는 teacher-studen distillation 파이프라인을 제거하고, ground-truth 멜을 target으로 하여 학습함

→ 이로써 diltilled 멜에서의 정보손실을 피하고, voice quality를 높임 - FastSpeech2에서는 variance adaptor를 통해 duration 뿐 아니라 pitch나 energy 등을 함께 predict하여 one-to-many problem을 해소함

- 이때, duration predictor는 forced alignment(McAuliffe et al., 2017) 방법을 통해 얻은 phoneme duration을 training 타겟으로 사용하여 autoregressive teacher model의 attention map에서 추출한 것보다 더 정확한 duration을 얻을 수 있도록 함

- 한편, 학습 파이프라인을 보다 간소화하기 위한 방안으로 text에서 바로 waveform을 생성하여 fully end-to-end 시스템으로 수 있행될 수 있는 FastSpeech2s를 제안

2.3 Variance Adaptor

Duration Predictor

Pitch Predictor

Energy Predictor

2.4 FastSpeech 2s

Challenges in Text-to-Waveform Generation

Our Method

2.5 Discussions

3. Experiments and Results

3.1 Experimental Setup

3.2 Results